数据去重是什么意思

数据去重是数据处理领域中的一个重要概念,主要用于去除数据集中的重复记录或值。随着信息化时代的到来,我们每天都会产生大量的数据,这些数据可能来自于各种不同的渠道和来源,如数据库、表格、文件等。在这些数据中,往往存在大量的重复数据,这不仅会占用更多的存储空间,而且会影响数据分析和处理的效果。因此,进行数据去重就显得尤为重要。

一、数据去重的含义

数据去重通常指通过对数据的检查、对比和处理,移除数据集中重复的记录或值的过程。这个过程可以帮助我们更有效地管理和分析数据,提高数据处理的速度和准确性。

二、数据去重的重要性

在大数据时代,数据去重的重要性不言而喻。以下是数据去重的几个重要性:

- 节省存储空间:重复的数据会占用额外的存储空间,进行数据去重后,可以有效地节省存储空间。

- 提高数据处理效率:处理大量的重复数据会消耗大量的计算资源和时间,去除重复数据后,可以大大提高数据处理的速度和效率。

- 保证数据分析的准确性:在数据分析中,如果存在大量的重复数据,那么分析的结果可能会受到干扰,导致结果不准确。去除重复数据后,可以保证数据分析的准确性。

三、数据去重的方法

根据不同的场景和需求,数据去重的方法也有所不同。以下是一些常见的数据去重方法:

- 基于主键去重:在数据库中,每个记录都有一个唯一标识的主键,通过比较主键是否相同,可以快速地去除重复的记录。

- 基于哈希算法去重:将数据通过哈希算法转化为一个固定长度的哈希值,然后比较这些哈希值是否相同,如果哈希值相同则认为数据是重复的。

- 基于内容相似度去重:对于非结构化数据(如文本、图片等),可以通过比较内容相似度来判断是否为重复数据。

四、数据去重的注意事项

在进行数据去重时,需要注意以下几点:

- 确保去重的准确性:在去重过程中,要确保方法的准确性和可靠性,避免误删或漏删。

- 保护数据的完整性:在去重过程中,要保护数据的完整性,避免在去除重复数据的同时损坏原始数据。

- 考虑数据的时效性:在进行数据去重时,要考虑到数据的时效性,避免因为数据的实时更新而产生新的重复数据。

五、总结

总的来说,数据去重是数据处理中一个非常重要的环节。通过对数据的去重处理,我们可以更有效地管理和分析数据,节省存储空间,提高数据处理和分析的效率和准确性。同时,我们也要注意在去重过程中保护数据的完整性和时效性,确保数据的准确性和可靠性。

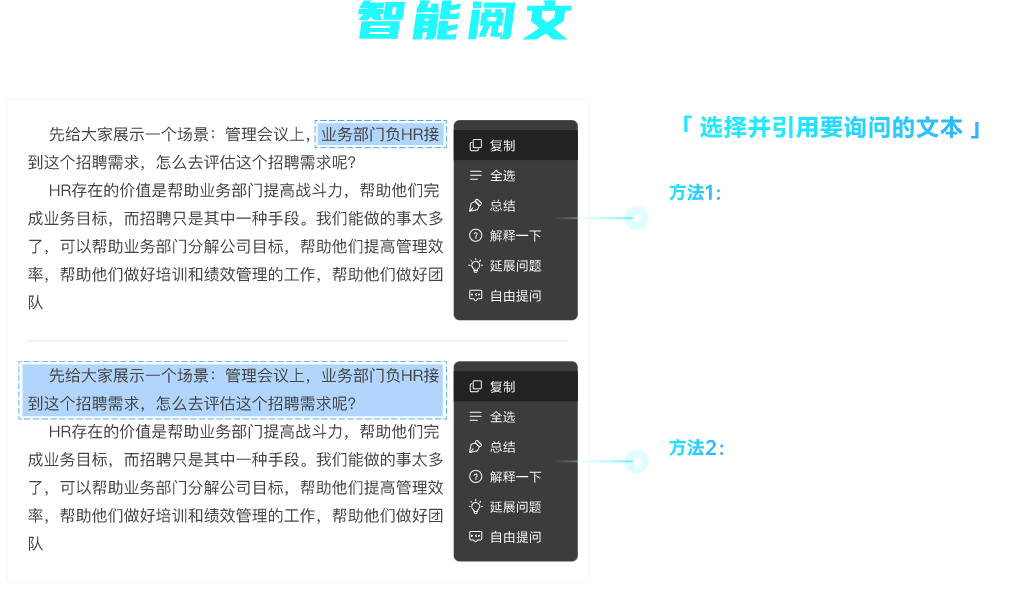

查看未读消息

查看未读消息 查看最新消息

查看最新消息

分享

分享

复制

复制 全选

全选 总结

总结 解释一下

解释一下 延展问题

延展问题 自由提问

自由提问

复制

复制 分享

分享